COVID-19 und die Grenze der Demokratie?

Einsatz von Künstlicher Intelligenz zur Überwachung von COVID-19-Maßnahmen

Ekaterina Jussupow und Armin Heinzl, Universität Mannheim

Wie sehr darf man durch Technologie in die Privatsphäre und Bewegungsfreiheit des Einzelnen eingreifen?

In Deutschland diskutiert man über den Einsatz von Tracking-Apps um den Verlauf der COVID-19 Erkrankung besser nachvollziehen zu können und Ansteckungen zu vermeiden. In anderen Ländern wurden hingegen bereits drastischere Maßnahmen ergriffen. So bedienen sich China und Russland an Algorithmen der Künstlichen Intelligenz (KI), um gegen Verstöße der Quarantänemaßnahmen in Echtzeit zu informieren. Die Algorithmen nutzen hierfür neuronale Netze, um Gesichter zu erkennen und diese dann mit einer bekannten Datenbank (etwa mit Passfotos der sich in Quarantäne befindenden Bürger) abzugleichen. Chinesische Unternehmen haben derartige Algorithmen bereits so weit entwickelt, dass sie in der Lage sind, Menschen, die eine Gesichtsmaske tragen, zu erkennen (Reuters). Allerdings ist über die Genauigkeit derartiger Algorithmen, die gegen COVID-19 zum Einsatz kommen, wenig bekannt. Hingegen verdeutlichen Berichte wie etwa der BBC über den Einsatz derartiger Algorithmen in Moskau, die Tragweite des Einsatzes dieser Algorithmen, als in nur wenigen Minuten nach Verlassen des Hauses die Polizei bereits über den Quarantäneverstoß informiert war.

Vor COVID-19 haben wir noch darüber diskutiert, welche ethischen und moralischen Implikationen von KI-Systemen ausgehen, darüber, dass Fehler in den Algorithmen vorliegen, und darüber, dass diese Algorithmen zu sehr in unser Leben eingreifen (Rahwan et al., 2019): Sie steuern, welche Informationen wir auf den sozialen Medien angezeigt bekommen, sind in der Lage Erkrankungen auf CT-Bildern zu erkennen oder darüber zu entscheiden, ob ein Bewerber für die Stellenanzeige passt. Erst vor kurzen hat die Wissenschaft begonnen, darüber zu diskutieren, welche Nebenwirkungen daraus entstehen und wie derartige Algorithmen neue Möglichkeiten erschaffen, menschliches Verhalten zu kontrollieren (Kellogg, Valentine and Christin, 2020). In Zeiten der COVID-19-Krise scheinen viele Bedenken vergessen – zu groß die Bedrohung durch diese neuartige Pandemie. Auf einmal wird in Deutschland über eine flächendeckende Erfassung von persönlichen Daten gesprochen, mit dem Ziel, die Verbreitung des Virus zu stoppen. Aber kann man wirklich von einer erhöhten Akzeptanz derartiger Technologien sprechen? Welche wissenschaftlichen Grundlagen liegen hier zugrunde?

In den Sozialwissenschaften und vor allem in der Psychologie findet die Theorie des Terror Managements (Greenberg, Pyszczynski and Solomon, 1986)große Verbreitung. Die Theorie besagt, dass die Bewusstheit unserer eigenen Vergänglichkeit (mortality salience) im Menschen das Bedürfnis hervorruft, sich auf Werte und Einstellungen zu besinnen, die das eigene Weltbild schützen. Das trifft vor allem auf konservative Weltsichten zu. So wurde zum Beispiel gezeigt, dass die Terroranschläge vom 11 September zu einer signifikant höheren Zustimmungsrate für den konservativen George W. Busch geführt haben (Landau et al., 2004), oder dass der Irak-Krieg die Zustimmungsrate für konservative Politik erhöhte (Lyall and Thorsteinsson, 2007). Man kann die Ergebnisse so verstehen, dass vor allem die bestehenden konservativen Einstellungen durch das Bewusstsein der eigenen Vergänglichkeit erhöht wurden. Doch würde sich diese Einstellung auch auf die Zustimmung zu KI- basierten Überwachungssystemen auswirken, die sehr stark in die Privatsphäre des Einzelnen eingreifen?

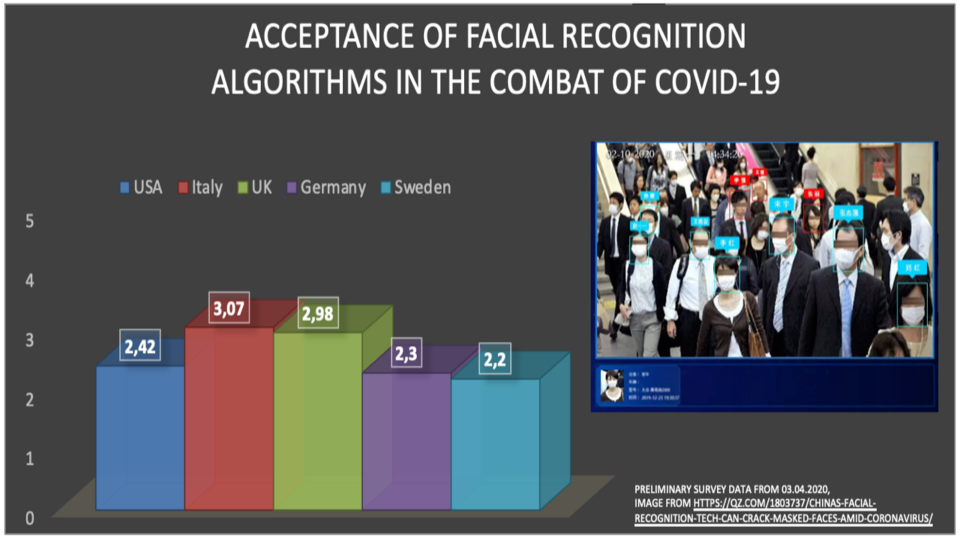

Um dies zu überprüfen, haben wir Anfang April eine erste Online-Studie über fünf Länder (USA, Italien, Großbritannien, Deutschland und Schweden) mit etwa 900 Teilnehmern durchgeführt. Wir fragten die Teilnehmer, inwieweit sie Aussagen wie „Gesichtserkennungsalgorithmen sollten das Verhalten aller infizierten und potenziell infizierten Personen überwachen“ zustimmen würden. Für die Analyse bezogen wir auch die relative Anzahl der Todesrate in dem jeweiligen Land der Befragten in unsere Betrachtung mit ein, ebenso wie ihre generelle Einstellung zu konservativen Werten und Bedenken zu Eingriffen in die Privatsphäre. Unsere erste Datenanalyse ergab, dass in der Tat die wahrgenommene Bedrohung durch das Virus, aber auch die relative Todesrate in dem Land, starken positiven Einfluss auf die Akzeptanz eines derartigen Einsatzes Künstlicher Intelligenz erhöht. Die folgende Abbildung veranschaulicht die Mittelwerte und die Standardabweichung der Zustimmung zur Benutzung von Gesichtserkennungsalgorithmen über die verschiedenen Länder hinweg. Auffällig ist, dass besonders Italien relativ hohe Zustimmungswerte aufweist, da zur Zeit der Datenerhebung die Krise dort die stärksten Folgen hatte. In Großbritannien rufen relativ geringe Befürchtungen in Bezug auf die Privatsphäre zusammen mit der hohen Bedrohung durch COVID-19 relativ hohe Zustimmungsraten hervor. In allen Ländern trägt die subjektiv wahrgenommene Bedrohung durch COVID-19 zur Erhöhung der Zustimmung zu derartigen Algorithmen bei (siehe Abbildung im Titelbild).

Bei diesen Ergebnissen muss der Einsatz von KI-Systemen sehr kritisch reflektiert werden. Wir nutzen diese Technologien und sie werden immer häufiger eingesetzt. Und auch wenn es noch nicht Realität in Deutschland ist, kann eine Krise wie COVID-19 schlagartig dazu führen, dass auch wir offener für Einschränkungen unserer Privatsphäre werden. Wir kommen nicht umhin, einen intensiven Austausch zwischen Bürgern und Wissenschaftlern zu pflegen, damit solche Ergebnisse dazu führen, dass wir darüber reflektieren, warum wir eigentlich jetzt so bereitwillig alle unsere Daten zum Wohle aller freigeben und warum wir im Gegensatz dazu solche Bedenken haben, unsere Daten für unser Gesundheitssystem zur Verfügung zu stellen. Eine Krise wie COVID-19 lädt zur gesellschaftlichen Reflektion ein und wir sollten bewusste Entscheidungen darüber treffen, wie wir langfristig mit der KI-Technologie umgehen. Uns sollte auch bewusst sein, dass unsere Zustimmung oder Ablehnung solcher Technologien nicht auf rationalen Überlegungen begründet ist (siehe auch Jussupow, Spohrer, Heinzl and Link, 2018), sondern auch durch gesellschaftliche Bewegungen beeinflusst werden kann.

Literatur

Greenberg, J., T. Pyszczynski and S. Solomon. (1986). “The Causes and Consequences of a Need for Self-Esteem: A Terror Management Theory.” In: Public Self and Private Self.

Jussupow, E., K. Spohrer, A. Heinzl and C. Link. (2018). “I am; We are - Conceptualizing Professional Identity Threats from Information Technology.” In: Proceedings of the International Conference on Information Systems - Bridging the Internet of People, Data, and Things. San Francisco.

Kellogg, K. C., M. A. Valentine and A. Christin. (2020). “Algorithms at work: The new contested terrain of control.” Academy of Management Annals, 14(1), 366–410.

Landau, M. J., S. Solomon, J. Greenberg, F. Cohen, T. Pyszczynski, J. Arndt, … A. Cook. (2004). “Deliver us from evil: The effects of mortality salience and reminders of 9/11 on support for President George W. Bush.” Personality and Social Psychology Bulletin, 30(9), 1136–1150.

Lyall, H. C. and E. B. Thorsteinsson. (2007). “Attitudes to the Iraq war and mandatory detention of asylum seekers: Associations with authoritarianism, social dominance, and mortality salience.” Australian Journal of Psychology, 59(2), 70–77.

Rahwan, I., M. Cebrian, N. Obradovich, J. Bongard, J. F. Bonnefon, C. Breazeal, … M. Wellman. (2019). “Machine behaviour.” Nature.